SENet思想非常简单,模型结构如下:

-

metapath2vec解读

metapath2vec在用在工业界的召回通路中比较多,非常适用于异构的K部图。

元路径 $P$ 定义形式如: $V_1 \rightarrow^{R_1} V_2 \rightarrow^{R_2} A_3 \ldots \rightarrow^{R_l} A_{l+1}$ 表示了从 $A_1$ 到 $A_{l+1}$ 的复杂关系。

其中 $V_i$ 表示节点类型,$R_i$ 表示节点间的关系。 $R=R_1 \circ R_2 \circ R_3 \circ R_l$,元路径 $P$ 的长度即为关系 $R$ 的个数。 -

常见的LLM推理加速解决方案

- KV Cache:用空间换时间

- 当decoder输入序列是 $t_1, t_2, \dots, t_n$ 时,预测$t_{n+1}$,只需利用到 $q^n$ 以及历史所有的 $k^i, v^i, i \in \{1,\dots,n \}$ :无须冗余attention计算 $h_1, \dots, h_{n-1}$ 以及 qkv映射 $q_1=W_q(t_1), k_1=W_k(t_1), k_1=W_v(t_1), \dots, q_{n-1}=W_q(t_{n-1}), k_1=W_k(t_{n-1}), k_1=W_v(t_{n-1})$

- KV Cache:用空间换时间

-

模型量化入门

量化已经是LLM部署和推理的必备环节了,在此了解一下:

-

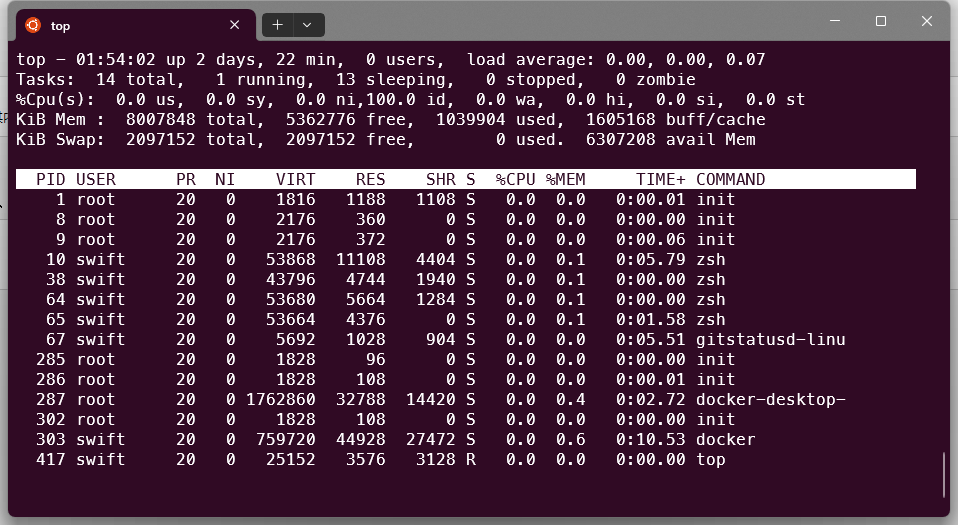

top命令

在linux运维中,经常用到

top命令,详细介绍一下:

-

alfred自定义谷歌翻译workflow

如果要实现自定义workflow,则必须安装付费版的alfred,囊中羞涩的话可以自行淘宝。自定义步骤如下:

-

LLM微调过程中灾难性遗忘问题解决方法

灾难性遗忘是LLM微调过程中最常见的问题,下面是一些解决办法:

-

Mixtral Moe代码解读

一直对稀疏专家网络好奇,有些专家没被选中,那么梯度是否为0,这一轮被选中有梯度,下一轮没被选中无梯度,模型可以训练收敛吗?

-

Win11+Docker搭建CUDA开发环境

最近入门了CUDA编程,先记录下搭建环境过程。

-

DPO讲解

PPO算法的pipeline冗长,涉及模型多,资源消耗大,且训练极其不稳定。DPO是斯坦福团队基于PPO推导出的优化算法,去掉了RW训练和RL环节,只需要加载一个推理模型和一个训练模型,直接在偏好数据上进行训练即可: